Python爬蟲(chóng)基礎(chǔ)講解之scrapy框架

網(wǎng)絡(luò)爬蟲(chóng)是指在互聯(lián)網(wǎng)上自動(dòng)爬取網(wǎng)站內(nèi)容信息的程序,也被稱作網(wǎng)絡(luò)蜘蛛或網(wǎng)絡(luò)機(jī)器人。大型的爬蟲(chóng)程序被廣泛應(yīng)用于搜索引擎、數(shù)據(jù)挖掘等領(lǐng)域,個(gè)人用戶或企業(yè)也可以利用爬蟲(chóng)收集對(duì)自身有價(jià)值的數(shù)據(jù)。

一個(gè)網(wǎng)絡(luò)爬蟲(chóng)程序的基本執(zhí)行流程可以總結(jié)三個(gè)過(guò)程:請(qǐng)求數(shù)據(jù),解析數(shù)據(jù),保存數(shù)據(jù)

數(shù)據(jù)請(qǐng)求

請(qǐng)求的數(shù)據(jù)除了普通的HTML之外,還有json數(shù)據(jù)、字符串?dāng)?shù)據(jù)、圖片、視頻、音頻等。

解析數(shù)據(jù)

當(dāng)一個(gè)數(shù)據(jù)下載完成后,對(duì)數(shù)據(jù)中的內(nèi)容進(jìn)行分析,并提取出需要的數(shù)據(jù),提取到的數(shù)據(jù)可以以多種形式保存起來(lái),數(shù)據(jù)的格式有非常多種,常見(jiàn)的有csv、json、pickle等

保存數(shù)據(jù)

最后將數(shù)據(jù)以某種格式(CSV、JSON)寫(xiě)入文件中,或存儲(chǔ)到數(shù)據(jù)庫(kù)(MySQL、MongoDB)中。同時(shí)保存為一種或者多種。

通常,我們想要獲取的數(shù)據(jù)并不只在一個(gè)頁(yè)面中,而是分布在多個(gè)頁(yè)面中,這些頁(yè)面彼此聯(lián)系,一個(gè)頁(yè)面中可能包含一個(gè)或多個(gè)到其他頁(yè)面的鏈接,提取完當(dāng)前頁(yè)面中的數(shù)據(jù)后,還要把頁(yè)面中的某些鏈接也提取出來(lái),然后對(duì)鏈接頁(yè)面進(jìn)行爬取(循環(huán)1-3步驟)。

設(shè)計(jì)爬蟲(chóng)程序時(shí),還要考慮防止重復(fù)爬取相同頁(yè)面(URL去重)、網(wǎng)頁(yè)搜索策略(深度優(yōu)先或廣度優(yōu)先等)、爬蟲(chóng)訪問(wèn)邊界限定等一系列問(wèn)題。

從頭開(kāi)發(fā)一個(gè)爬蟲(chóng)程序是一項(xiàng)煩瑣的工作,為了避免因制造輪子而消耗大量時(shí)間,在實(shí)際應(yīng)用中我們可以選擇使用一些優(yōu)秀的爬蟲(chóng)框架,使用框架可以降低開(kāi)發(fā)成本,提高程序質(zhì)量,讓我們能夠?qū)W⒂跇I(yè)務(wù)邏輯(爬取有價(jià)值的數(shù)據(jù))。接下來(lái),就帶你學(xué)習(xí)目前非常流行的開(kāi)源爬蟲(chóng)框架Scrapy。

scrapy安裝scrapy官網(wǎng):https://scrapy.org/scrapy中文文檔:https://www.osgeo.cn/scrapy/intro/overview.html

安裝方式

在任意操作系統(tǒng)下,可以使用pip安裝Scrapy,例如:

pip install scrapy

安裝完成后我們需要測(cè)試安裝是否成功,通過(guò)如下步驟確認(rèn):

在終端中測(cè)試能否執(zhí)行scrapy這條命令

scrapy 2.4.0 - no active project usage: scrapy <command>[options] [args] Available commands : benchRun quick benchmark test fetchFetch a URL using the scrapy down1oader genspiderGenerate new spider using pre-defined temp1ates runspiderRun a self-contained spider (without creating a project) settingsGet settings values she11Interactive scraping console startprojectcreate new project versionPrint scrapy version viewopen URL in browser,as seen by scrapy [ more ]More commands available when run from project directory use 'scrapy <command> -h' to see more info about a command

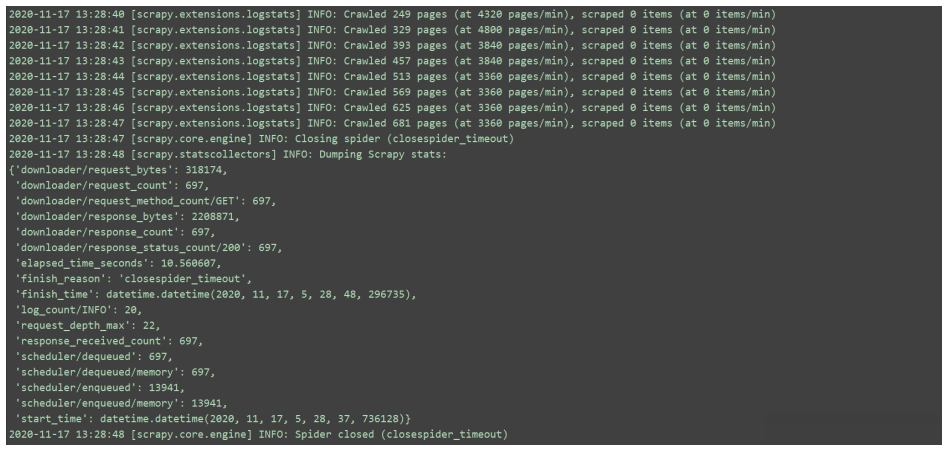

輸入scrapy bench測(cè)試連通性,如果出現(xiàn)以下情況表示安裝成功:

通過(guò)了以上兩項(xiàng)檢測(cè),說(shuō)明Scrapy安裝成功了。如上所示,我們安裝的是當(dāng)前最新版本2.4.0。

注意:

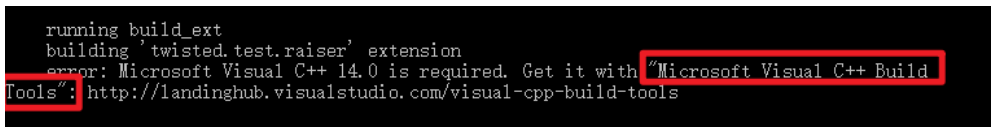

在安裝Scrapy的過(guò)程中可能會(huì)遇到缺少VC++等錯(cuò)誤,可以安裝缺失模塊的離線包

成功安裝后,在CMD下運(yùn)行scrapy出現(xiàn)上圖不算真正成功,檢測(cè)真正是否成功使用scrapybench測(cè)試,如果沒(méi)有提示錯(cuò)誤,就代表成功安裝。

全局命令

scrapy 2.4.0 - no active project usage: scrapy <command>[options] [args] Available commands : bench Run quick benchmark test #測(cè)試電腦性能 fetch Fetch a URL using the scrapy down1oader#將源代碼下載下來(lái)并顯示出來(lái) genspider Generate new spider using pre-defined temp1ates#創(chuàng)建一個(gè)新的spider文件 runspider Run a self-contained spider (without creating a project)# 這個(gè)和通過(guò)craw1啟動(dòng)爬蟲(chóng)不同,scrapy runspider爬蟲(chóng)文件名稱 settings Get settings values#獲取當(dāng)前的配置信息 she11 Interactive scraping console#進(jìn)入scrapy 的交互模式 startproject create new project#創(chuàng)建爬蟲(chóng)項(xiàng)目 version Print scrapy version#顯示scrapy框架的版本 view open URL in browser,as seen by scrapy#將網(wǎng)頁(yè)document內(nèi)容下載下來(lái),并且在瀏覽器顯示出來(lái) [ more ] More commands available when run from project directoryuse 'scrapy <command> -h' to see more info about a command

項(xiàng)目命令

scrapy startproject projectname 創(chuàng)建一個(gè)項(xiàng)目 scrapy genspider spidername domain 創(chuàng)建爬蟲(chóng)。創(chuàng)建好爬蟲(chóng)項(xiàng)目以后,還需要?jiǎng)?chuàng)建爬蟲(chóng)。 scrapy crawl spidername 運(yùn)行爬蟲(chóng)。注意該命令運(yùn)行時(shí)所在的目錄。到此這篇關(guān)于Python爬蟲(chóng)基礎(chǔ)講解之scrapy框架的文章就介紹到這了,更多相關(guān)Python scrapy框架內(nèi)容請(qǐng)搜索好吧啦網(wǎng)以前的文章或繼續(xù)瀏覽下面的相關(guān)文章希望大家以后多多支持好吧啦網(wǎng)!

相關(guān)文章:

1. python軟件測(cè)試Jmeter性能測(cè)試JDBC Request(結(jié)合數(shù)據(jù)庫(kù))的使用詳解2. ASP錯(cuò)誤捕獲的幾種常規(guī)處理方式3. python numpy.power()數(shù)組元素求n次方案例4. python基于opencv批量生成驗(yàn)證碼的示例5. python uuid生成唯一id或str的最簡(jiǎn)單案例6. npm下載慢或下載失敗問(wèn)題解決的三種方法7. ASP編碼必備的8條原則8. python用pyecharts實(shí)現(xiàn)地圖數(shù)據(jù)可視化9. 如何用python開(kāi)發(fā)Zeroc Ice應(yīng)用10. 使用Spry輕松將XML數(shù)據(jù)顯示到HTML頁(yè)的方法

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備